当前位置: AI资讯 > 内文

当前位置: AI资讯 > 内文2021-3-16 关键词: 医疗AI

机器学习算法作为预测建模最先进的技术,把医疗AI推向了新的发展高峰,为临床提供疾病诊断、风险预测等决策支持。然而,机器学习算法的突破虽然提高了预测模型的性能,但其难以解释的推理过程被视为“黑闸子”思维,降低了终端用户的信任度。

最近,一项发表在《公共科学图书馆》(Public Library of Science)的研究显示,在预测卒中患者3个月预后中,人工神经网络(ANN)、渐进决策树等机器学习算法的计算推理具有可解释性,这将极大地推动临床决策支持系统的发展。

01可解释性评价决策树算法表现最优机器学习算法的快速发展,让线性回归、逻辑回归等建模技术归于传统算法行列。但相比新一代算法的“黑闸子”决策,能够解释推理过程的传统算法似乎更受信任。有人认为,AI系统必须具备两种可解释性:一是能够对推算结果进行解释与合理性评价;二是系统知识来源可获得医生信任。

高性能与可解释性的不可兼备似乎让研发人员陷入选择困境。幸运的是,人工神经网络、渐进决策树等机器学习算法的出现打破了这种局面。它们既使预测模型变得更“聪明”,也能够对特征重要性进行排序,使决策结果可被解释。

来自德国柏林卒中研究中心、柏林大学的研究人员,分别使用人工神经网络、渐进决策树、逻辑回归三种算法进行建模,利用预测模型对卒中患者进行改良Rankin量表评估,预测患者3个月的预后,由此比较三种算法的可解释性与性能。

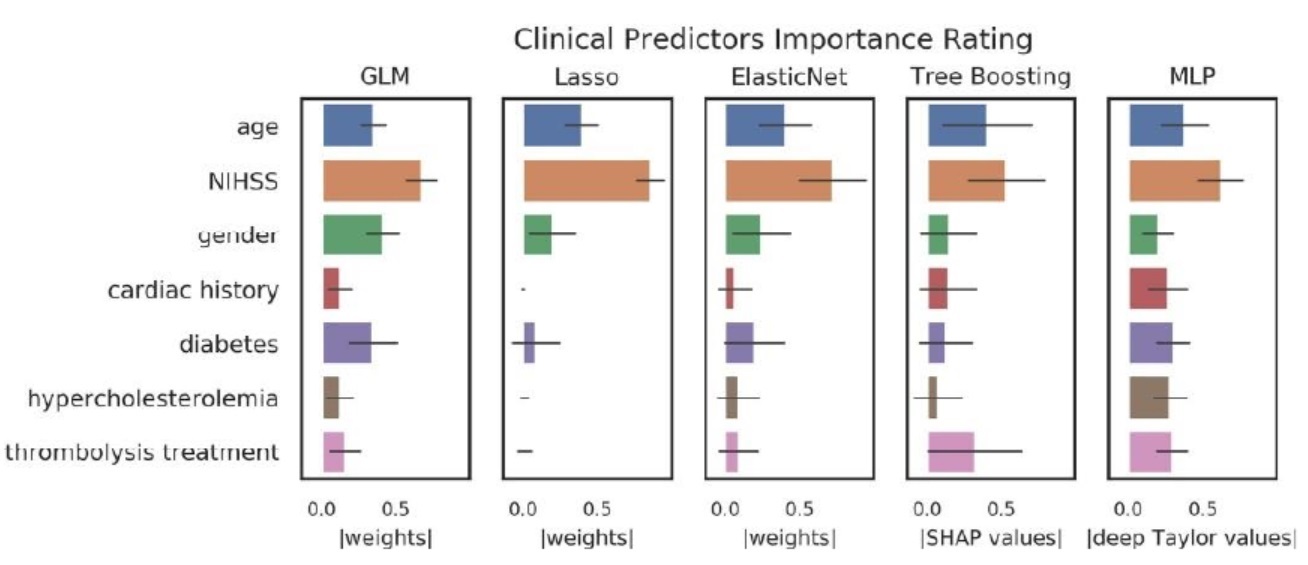

本次研究纳入了314例急性缺血性卒中患者的病例数据,每例均包括年龄、性别、NIHSS评分、心脏病史、溶栓治疗等7项临床特征,这7项特征也是决定患者预后的重要因素(表1)。通过评价三种算法模型在预测过程中对各项临床特征的排序,推导出模型的可解释性。结果显示,三种算法在推算过程中,均将年龄与初始NIHSS评分作为最重要的特征之一,在其余特征的排序上,则存在一定差异。说明机器学习算法的推理并非“黑闸子”,而是依从于知识规则与临床循证证据。

表1 与卒中患者预后相关的7项重要临床信息

值得一提的是,在此次研究中,渐进决策树算法推出了最恰当、最完整的特征排序,并且将“年龄”与“NIHSS”排在最前端,其后是“溶栓”(图1)。同时,决策树模型也较人工神经网络更易训练,在医疗领域中应用具有很大的优势。

图2 不同算法模型的临床特征排序

02性能相当?简单数据集下难以作出评价在本次研究中,人工神经网络、渐进决策树、逻辑回归三种算法模型表现出的性能相当,AUC值分别为0.83、0.81、0.83(图2)。但研究人员表示,性能评价并非本次研究的重点,目的在于比较算法的可解释性能力。

图3 不同算法模型的性能比较

研究人员指出,为评价算法模型的推理过程,本次采用基于特征排序进行综合评分的项目,在特征明显的简单数据集下,传统算法有能力捕捉临床特征与风险预测的关系,从而表现出与新一代算法相同的性能。但在临床实际应用中,面对大体量、复杂的医疗数据,传统算法显然难以胜任实时、准确决策的角色。人工神经网络与决策树仍是当前医疗AI通用、且性能良好的算法。

文章最后总结,这项研究是首次对新一代算法与传统算法进行可解释性验证与比较,结果非常令人鼓舞人心,未来可进一步验证不同用途的知识模型的可解释性,使医疗AI更好地被用户信任及发展。

参考文献:

https://www.researchgate.net/publication/340468878

想了解更多产品信息或预约产品演示?我们的专业团队随时为您服务